前回の記事で圧倒的な実力を見せてくれたChatGPT。

今回は前回に引き続きChatGPTを使って機械学習モデルを複数構築して予測精度を比較していく。

ChatGPTでECサイトの商品販売個数を予測

前回に引き続きKaggleのデータセット E-Commerce Summer Product Ratings and Sales を使った。

複数アルゴリズムで商品販売個数の予測精度を比較する

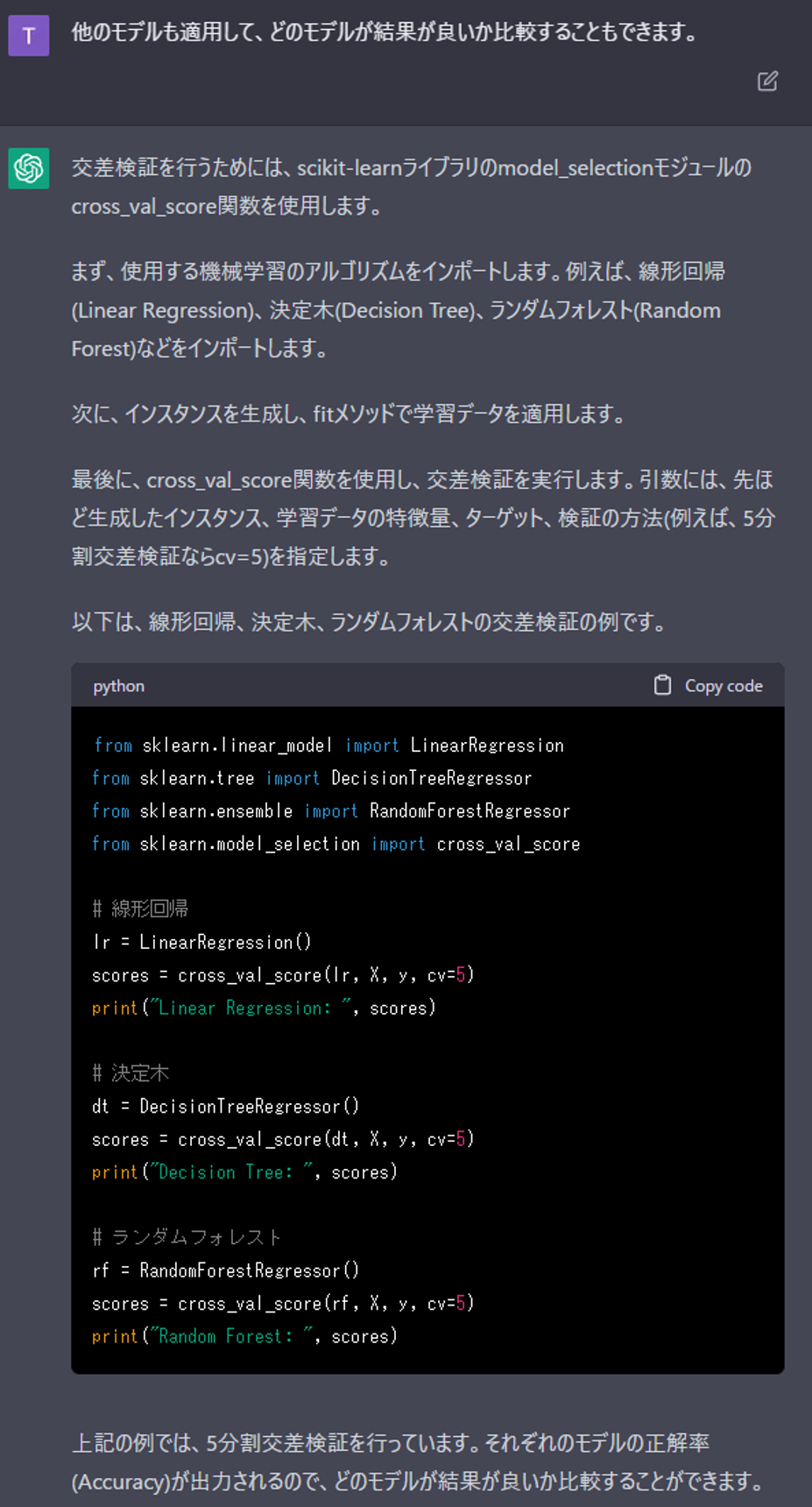

線形回帰、決定木、ランダムフォレストでモデル構築。

score値を比較した。

データセットのインポートや線形回帰での検討は前回の記事を参照ください。

ChatGPTに機械学習でECの売り上げ予測させてみた

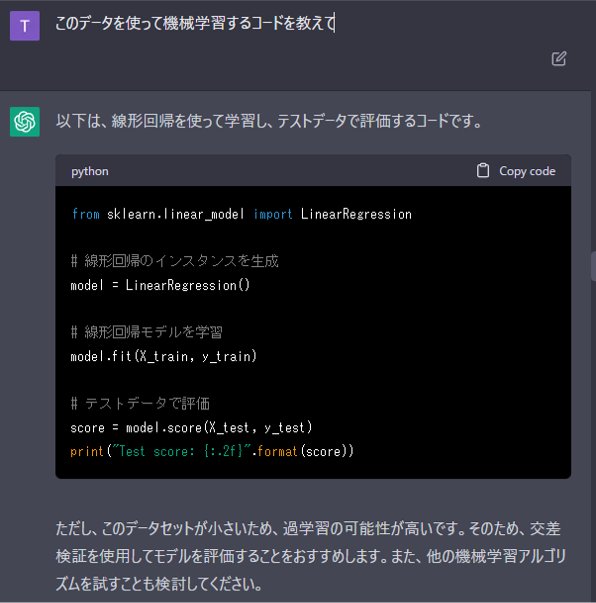

モデル構築

あらかじめ生成していた訓練データを使ってモデルを学習と、score値の出力までサクッとやってくれます。

交差検証でのモデル評価のアドバイスまで。

優秀だなほんと。

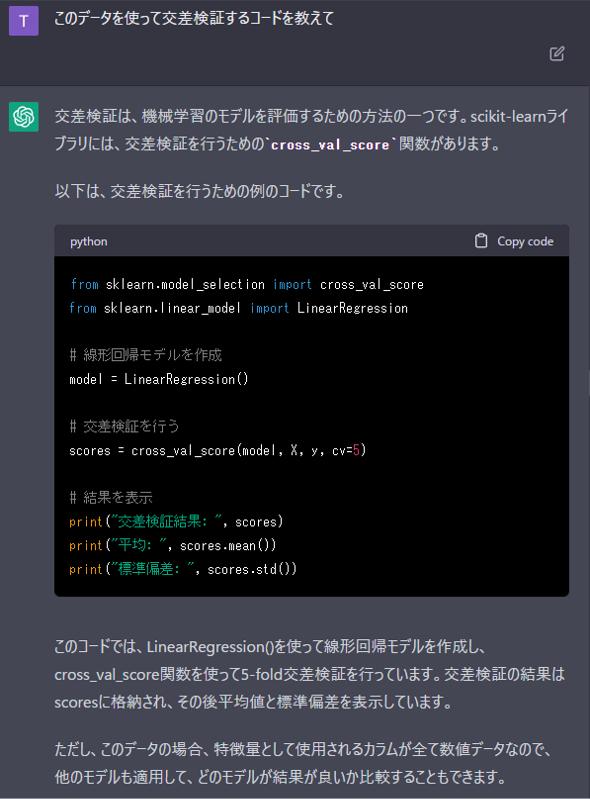

交差検証

おすすめされた交差検証を実施。

交差検証についてはこちらの記事を参考に。

交差検証(Python実装)を徹底解説!(codexa)

複数モデルで比較検討

3種類のモデルを用いて比較検討するコードを教えてくれた。

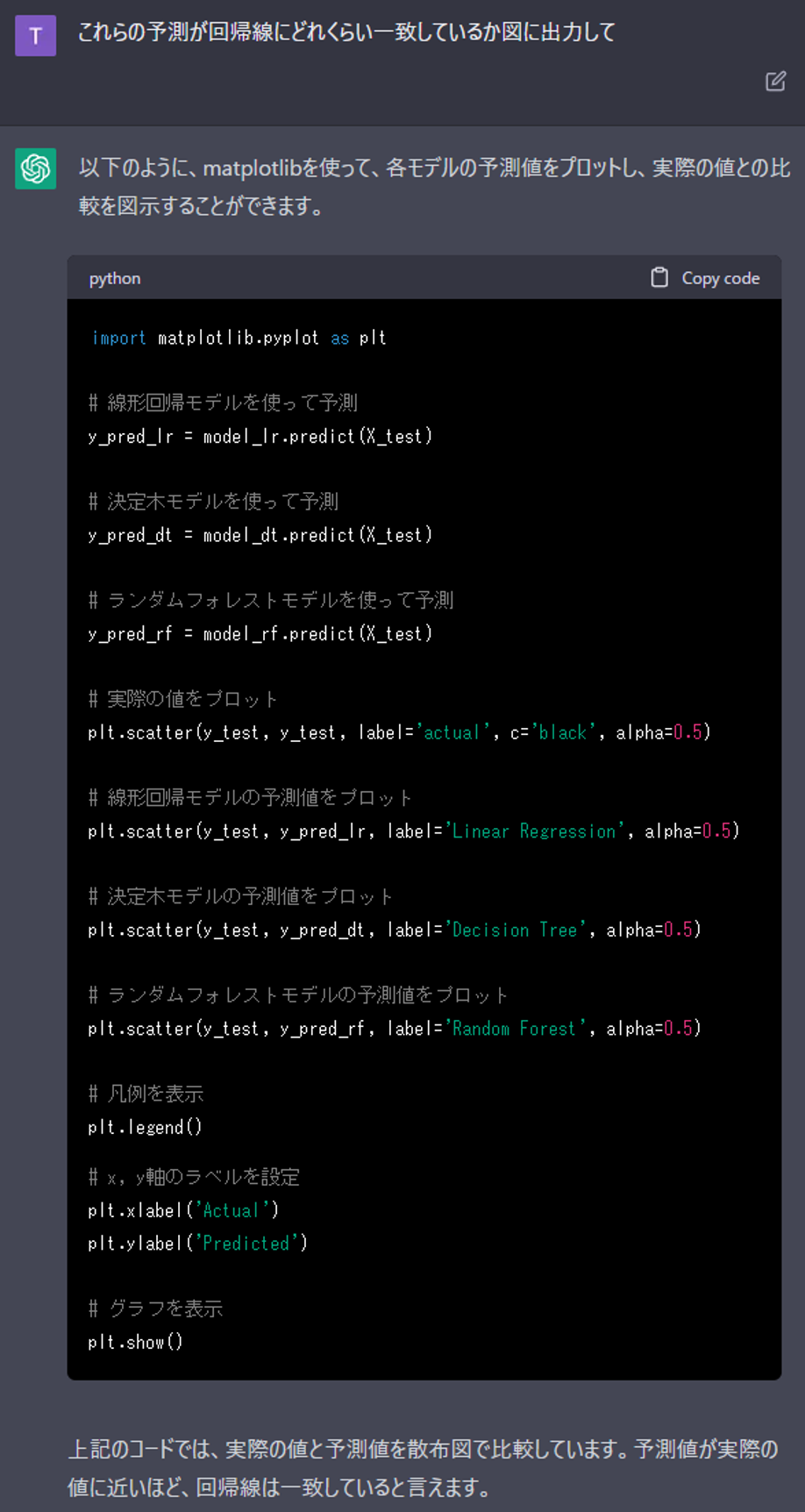

結果の可視化

今回構築したモデルでは決定木が最も予測精度が高かった.

今回のデータセットの特徴量では決定木が相性が良かったようだ。

以上、ChatGPTを用いて簡単に機械学習モデルの比較ができた。

ChatGPTをコードアシスタントにしていて困ったこと

ChatGPTはコーディングのアシスタントとして優秀であることが良く分かった。

しかし一方で、やや改善を望む点もあった。

- モデル名や変数名のゆらぎ

期待する回答が得られなかった場合に、言い回しを少しずつ変えて、狙い通りのへんとうが得られるまで何度か質問を繰り返すことがある。

その場合、回答で使われるモデル名や変数名にゆらぎが生じ、コピペ先で適切に修正する必要がある。 - jupyter notebookからAPIで呼び出すと表示が崩れる

webアプリで質問、答えをjupyterにコピペする作業は面倒。

jupyter上でAPIでChatGPTを呼び出せる。が、しかし、日本語呼びかけると、出力がHTMLのような文字列が出力され読みとれない。(自力で頑張って直すのも面倒そう)

twwiterでよく見かける、ChatGPT×GoogleSpredsheetでやってみるのもあり。

まとめ

ChatGPTのアシスタントで3種類の機械学習モデルをあっという間に比較検討することができた。

すぐに実践レベルで使えてしまうのに驚きだ。

もうしばらくこいつで遊ぼう。

以上、最後まで読んでいただきありがとうございました。

最後に今回ChatGPTのアシスタントで作成したコードを掲載する。

<script async src="https://pagead2.googlesyndication.com/pagead/js/adsbygoogle.js?client=ca-pub-6680483121186966"

crossorigin="anonymous">